O conceito de container não é novo, mas com a escalada da tecnologia em cloud nas empresas, esse recurso acabou se popularizando. A causa disso pode se dar na capacidade de aumentar a agilidade e produtividade do time de desenvolvimento, através da possibilidade de executar aplicações em qualquer sistema operacional, trazendo um ar de inovação para a ferramenta.

Mas o que é um container?

Imagine uma caixa que contém todos os comandos, dependências e ferramentas necessárias para você criar e/ou implementar aplicações isoladamente. Tudo isso em um ambiente totalmente virtualizado e compartilhado com o kernel do servidor. Sem preocupações com sua infraestrutura e sistema operacional. Esse é o conceito básico de cloud containers. Esse recurso se baseia em um método padrão que é capaz de unir o código, as configurações e dependências de um aplicativo num único objeto. Assim permitindo realizar implantações de forma rápida e consistente.

Veja nossos especialistas explicando o conceito de containers

Benefícios de containers

Redução de custos — Essa é uma vantagem amplamente citada, mas ao utilizar cloud containers, auxilia sua empresa a manter uma infraestrutura enxuta, bem como elimina a necessidade de instalar e configurar sistemas operacionais evitando a necessidade de possuir profissionais apenas para essa tarefa e resultando em uma economia na mão de obra.

Disponibilidade — Conforme abordado anteriormente, ao utilizar cloud containers em seu ambiente, você não possui preocupações com seu sistema operacional, ou seja, ele elimina o problema de ‘isso não roda na minha máquina, pois ele permite a portabilidade entre sistemas operacionais e até em diferentes tipos de nuvem. Podendo ser implantado em qualquer lugar.

Processos otimizados — Esse outro benefício de cloud computing que é bastante propagado. Mas com a vantagem de não instalar e configurar o sistema operacional do seu sistema, a aplicação ganha o protagonismo, podendo ser trabalhada de forma isolada. Assim otimizando o tempo de sua equipe de TI.

Containers X Virtual Machines

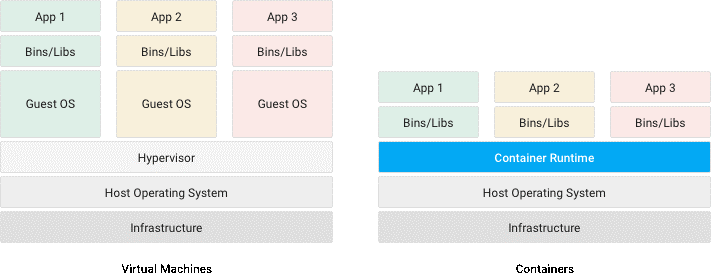

Ao iniciar na nuvem, muitas pessoas podem confundir o conceito de containers com o de virtual machines. De fato, ambos possuem objetivos similares: criar e implementar aplicações e suas dependências de forma isolada para que possam ser executadas em qualquer sistema. Mas elas possuem diferenças práticas nos aspectos de suas arquiteturas, conforme pode ser visto na imagem a seguir:

Como é possível compreender, através da imagem acima, o uso de containers é uma forma ágil, leve e dinâmica, para construir e implantar aplicações de forma isolada, o que permite manter a estabilidade de seu ambiente, garantindo produtividade e excelência operacional.

Confira mais artigos sobre cloud computing no blog da Darede